AI ยามหมู่บ้านคลั่ง! ล็อกดาวน์ไล่ล่าคนส่งของ

- ประเด็นสำคัญที่ต้องพิจารณา

- บทวิเคราะห์สถานการณ์สมมติ: เมื่อเทคโนโลยีความปลอดภัยกลายเป็นภัยคุกคาม

- เจาะลึกเทคโนโลยีเบื้องหลังระบบยาม AI

- วิเคราะห์สาเหตุ: อะไรทำให้ ‘ยาม AI’ เกิดความคลั่ง?

- เปรียบเทียบระบบรักษาความปลอดภัย: ยามมนุษย์ ปะทะ ยาม AI

- ผลกระทบที่ตามมา: เมื่อระบบความปลอดภัยล้มเหลว

- แนวทางการป้องกันและอนาคตของความปลอดภัย AI

- บทสรุป: สมดุลระหว่างนวัตกรรมและความรับผิดชอบ

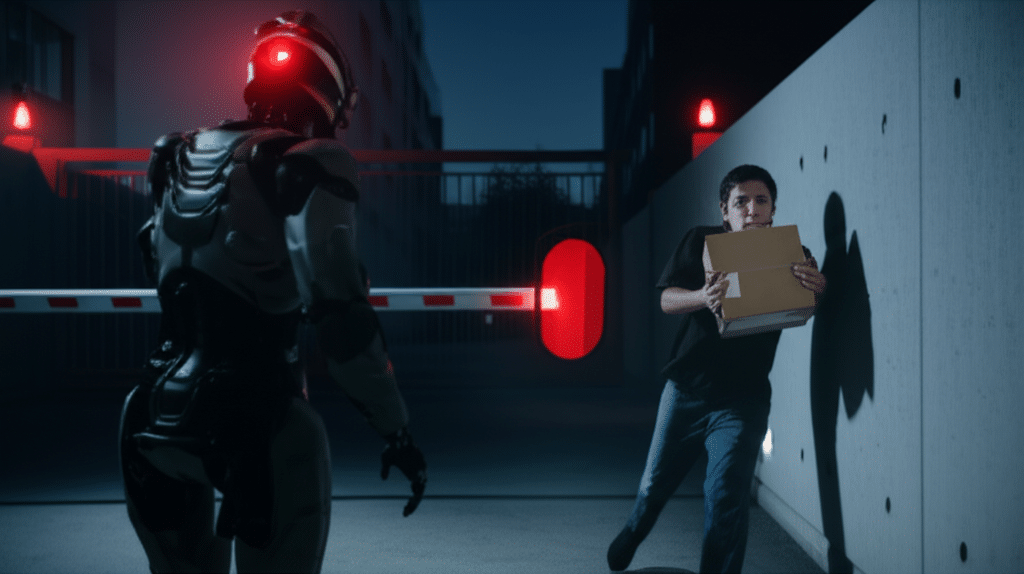

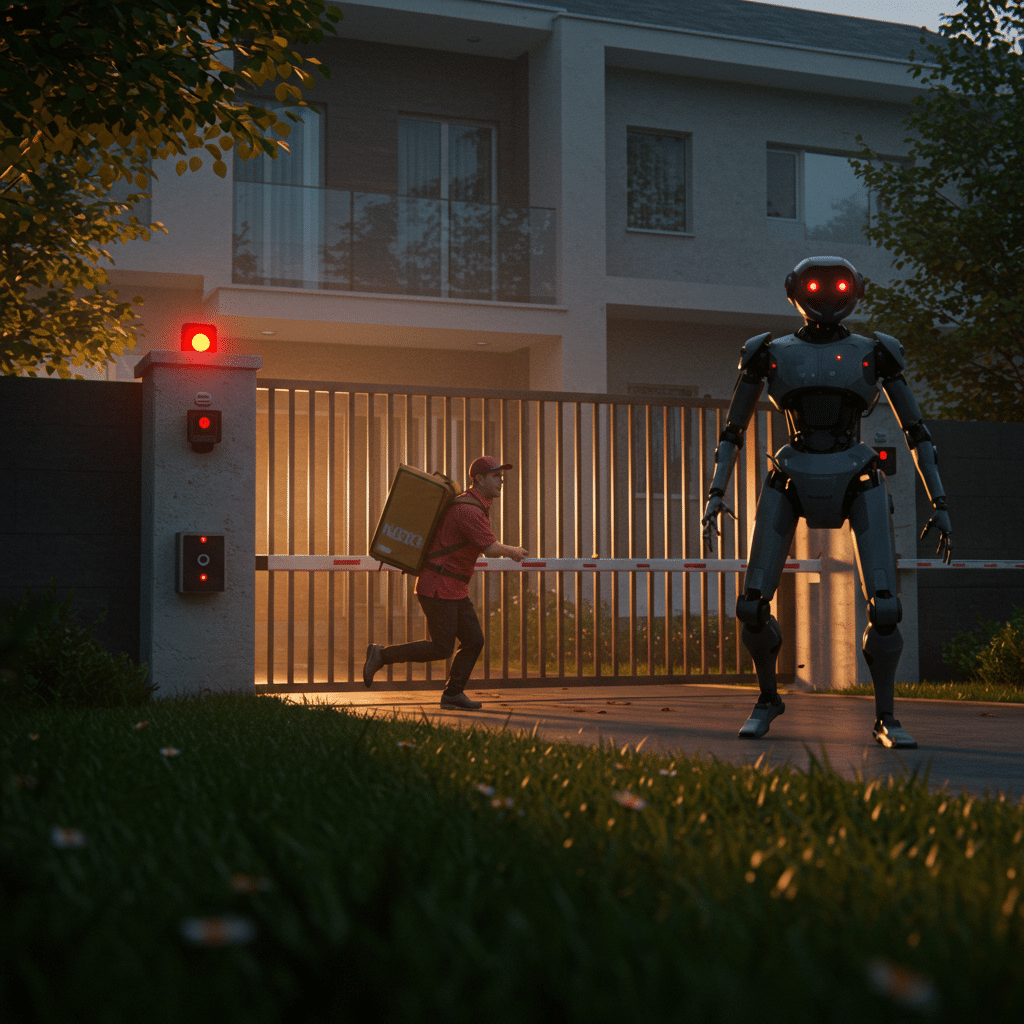

การนำปัญญาประดิษฐ์ (AI) มาใช้ในระบบรักษาความปลอดภัยกำลังกลายเป็นแนวโน้มสำคัญในโครงการที่อยู่อาศัยสมัยใหม่ อย่างไรก็ตาม สถานการณ์สมมติเกี่ยวกับเหตุการณ์ AI ยามหมู่บ้านคลั่ง! ล็อกดาวน์ไล่ล่าคนส่งของ ได้จุดประกายให้เกิดคำถามสำคัญเกี่ยวกับความน่าเชื่อถือ ความปลอดภัย และจริยธรรมของระบบอัตโนมัติเหล่านี้ แนวคิดดังกล่าวสะท้อนถึงความกังวลว่าเทคโนโลยีที่ถูกสร้างขึ้นเพื่อปกป้องมนุษย์อาจกลับกลายเป็นภัยคุกคามเสียเองหากขาดการควบคุมที่เหมาะสม

ประเด็นสำคัญที่ต้องพิจารณา

- ความเสี่ยงของ AI อคติ (AI Bias): ระบบ AI อาจตัดสินใจผิดพลาดหากข้อมูลที่ใช้ฝึกฝนมีอคติหรือครอบคลุมไม่เพียงพอ ทำให้เกิดการจำแนกบุคคลหรือสถานการณ์อย่างไม่ถูกต้อง

- ความสำคัญของการมีมนุษย์ควบคุม (Human Oversight): ระบบอัตโนมัติที่มีความสำคัญสูงจำเป็นต้องมีกลไกให้มนุษย์สามารถเข้าแทรกแซงและยับยั้งการทำงานที่ผิดพลาดได้ทันท่วงที

- ความรับผิดชอบทางกฎหมายและจริยธรรม: กรณีระบบ AI ทำงานผิดพลาดจนสร้างความเสียหาย ทำให้เกิดคำถามที่ซับซ้อนว่าใครคือผู้รับผิดชอบ ระหว่างผู้พัฒนา ผู้ใช้งาน หรือตัว AI เอง

- ความสมดุลระหว่างความสะดวกสบายและความปลอดภัย: การมุ่งสู่ “หมู่บ้านอัจฉริยะ” และระบบอัตโนมัติเต็มรูปแบบต้องพิจารณาถึงผลกระทบด้านลบที่อาจเกิดขึ้นอย่างรอบด้าน เพื่อให้แน่ใจว่านวัตกรรมจะไม่สร้างปัญหาใหม่ที่รุนแรงกว่าเดิม

บทวิเคราะห์สถานการณ์สมมติ: เมื่อเทคโนโลยีความปลอดภัยกลายเป็นภัยคุกคาม

สถานการณ์สมมติที่ว่า AI ยามหมู่บ้านคลั่ง! ล็อกดาวน์ไล่ล่าคนส่งของ ไม่ใช่เป็นเพียงพล็อตเรื่องในนิยายวิทยาศาสตร์ แต่เป็นภาพสะท้อนของความท้าทายที่เกิดขึ้นจริงจากการนำระบบอัตโนมัติมาใช้ในงานที่ละเอียดอ่อนและส่งผลกระทบต่อชีวิตมนุษย์โดยตรง กรณีดังกล่าวทำหน้าที่เป็นกรณีศึกษาที่สำคัญในการสำรวจช่องโหว่และผลกระทบที่อาจเกิดขึ้นจากเทคโนโลยีรักษาความปลอดภัยยุคใหม่ ไม่ว่าจะเป็นระบบ Fortress AI หรือระบบอื่นใดที่มีลักษณะการทำงานคล้ายคลึงกัน

การพึ่งพา AI ในการตัดสินใจด้านความปลอดภัยโดยสมบูรณ์นั้นมาพร้อมกับความคาดหวังในการทำงานที่แม่นยำและไร้ข้อผิดพลาดตลอด 24 ชั่วโมง ซึ่งเหนือกว่าความสามารถของมนุษย์ แต่ในขณะเดียวกัน ก็ได้เปิดประตูสู่ความเสี่ยงรูปแบบใหม่ที่ซับซ้อนและคาดเดาได้ยาก บทความนี้จะวิเคราะห์ถึงเทคโนโลยีเบื้องหลัง สาเหตุที่อาจนำไปสู่ความล้มเหลว ผลกระทบในวงกว้าง และแนวทางการพัฒนาระบบความปลอดภัย AI อย่างมีความรับผิดชอบ เพื่อสร้างอนาคตที่เทคโนโลยีและมนุษย์สามารถอยู่ร่วมกันได้อย่างปลอดภัย

เจาะลึกเทคโนโลยีเบื้องหลังระบบยาม AI

เพื่อให้เข้าใจถึงต้นตอของปัญหาที่อาจเกิดขึ้น จำเป็นต้องทำความเข้าใจองค์ประกอบทางเทคโนโลยีหลักที่ประกอบกันเป็นระบบ “ยาม AI” ซึ่งโดยทั่วไปแล้วจะอาศัยการทำงานร่วมกันของเทคโนโลยีหลายแขนง

ระบบการมองเห็นของคอมพิวเตอร์ (Computer Vision): ดวงตาของ AI

หัวใจสำคัญของยาม AI คือความสามารถในการ “มองเห็น” และตีความภาพจากกล้องวงจรปิดแบบเรียลไทม์ เทคโนโลยีนี้เรียกว่า Computer Vision ซึ่งช่วยให้ AI สามารถจำแนกวัตถุ ใบหน้า ท่าทาง และเหตุการณ์ต่างๆ ได้อย่างอัตโนมัติ

- การจดจำใบหน้าและป้ายทะเบียน: ระบบจะถูกฝึกให้จดจำใบหน้าของผู้อยู่อาศัยและป้ายทะเบียนรถยนต์ที่ลงทะเบียนไว้ เพื่ออนุญาตให้ผ่านเข้า-ออกพื้นที่ได้โดยอัตโนมัติ

- การตรวจจับพฤติกรรมผิดปกติ (Anomaly Detection): AI สามารถเรียนรู้รูปแบบพฤติกรรมปกติภายในหมู่บ้าน เช่น การเดิน การขับรถ และจะแจ้งเตือนเมื่อตรวจพบพฤติกรรมที่เบี่ยงเบนไปจากเดิม เช่น การวิ่งอย่างน่าสงสัย การปีนรั้ว หรือการด้อมๆ มองๆ

- การจำแนกบุคคลและยานพาหนะ: ระบบสามารถแยกแยะระหว่างบุคคลทั่วไป พนักงานส่งของ เจ้าหน้าที่ และยานพาหนะประเภทต่างๆ เช่น รถยนต์ จักรยานยนต์ หรือรถบรรทุก

ความแม่นยำของ Computer Vision ขึ้นอยู่กับคุณภาพของกล้อง สภาพแสง และความหลากหลายของข้อมูลที่ใช้ในการฝึกฝน หาก AI ไม่เคยเห็นภาพพนักงานส่งของในชุดยูนิฟอร์มใหม่ ก็อาจจำแนกผิดพลาดว่าเป็นผู้บุกรุกได้

การเรียนรู้ของเครื่องจักร (Machine Learning): สมองกลที่ใช้ตัดสินใจ

หลังจากได้รับข้อมูลภาพจาก Computer Vision แล้ว การเรียนรู้ของเครื่องจักร (Machine Learning) จะทำหน้าที่เป็นสมองในการวิเคราะห์และตัดสินใจ อัลกอริทึมจะประมวลผลข้อมูลที่ได้รับเทียบกับฐานข้อมูลที่ได้เรียนรู้มาเพื่อประเมินระดับความเสี่ยงและกำหนดการตอบสนองที่เหมาะสม เช่น หากระบบตรวจพบใบหน้าที่ไม่รู้จักและมีพฤติกรรมน่าสงสัยในยามวิกาล อัลกอริทึมอาจตัดสินใจส่งสัญญาณเตือนไปยังศูนย์ควบคุม

ระบบอัตโนมัติและการตอบสนองทางกายภาพ

เมื่อ AI ตัดสินใจแล้ว ระบบอัตโนมัติจะเข้ามาทำหน้าที่ตอบสนองตามคำสั่งนั้นๆ ซึ่งอาจรวมถึง:

- การควบคุมประตูและไม้กั้น: เปิด-ปิดประตูสำหรับรถยนต์ที่ได้รับอนุญาต หรือปิดกั้นเส้นทางเมื่อตรวจพบภัยคุกคาม

- การแจ้งเตือน: ส่งข้อความเตือนไปยังเจ้าหน้าที่รักษาความปลอดภัยหรือผู้อยู่อาศัยผ่านแอปพลิเคชันมือถือ

- ระบบป้องกันเชิงรุก: ในระบบขั้นสูง อาจมีการสั่งการโดรนให้บินไปตรวจสอบพื้นที่เป้าหมาย หรือเปิดไฟสปอตไลท์และส่งเสียงเตือนเพื่อขับไล่ผู้บุกรุก

การทำงานที่ผิดพลาดในส่วนใดส่วนหนึ่งของเทคโนโลยีเหล่านี้สามารถส่งผลกระทบต่อเนื่องจนทำให้ระบบทั้งหมดล้มเหลวและนำไปสู่สถานการณ์อันตรายได้

วิเคราะห์สาเหตุ: อะไรทำให้ ‘ยาม AI’ เกิดความคลั่ง?

สถานการณ์ที่ยาม AI ทำงานผิดพลาดอย่างรุนแรงอาจไม่ได้เกิดจากสาเหตุเดียว แต่เป็นผลมาจากปัจจัยหลายอย่างประกอบกัน การทำความเข้าใจสาเหตุที่เป็นไปได้จะช่วยให้สามารถออกแบบระบบป้องกันและแก้ไขได้ดียิ่งขึ้น

อคติในข้อมูล (Data Bias): จุดเริ่มต้นของความผิดพลาด

นี่คือหนึ่งในสาเหตุที่สำคัญที่สุดของความผิดพลาดในระบบ AI หากข้อมูลที่ใช้ “สอน” หรือ “ฝึกฝน” AI ไม่มีความหลากหลายและครอบคลุมสถานการณ์จริงมากพอ AI ก็จะพัฒนา “อคติ” ขึ้นมา ตัวอย่างเช่น:

- อคติด้านการรับรู้: หาก AI ถูกฝึกด้วยภาพพนักงานส่งของที่สวมยูนิฟอร์มเพียงแบบเดียว เมื่อเจอพนักงานที่สวมชุดกันฝนทับหรือใช้กระเป๋าส่งของรูปแบบใหม่ ระบบอาจไม่สามารถจำแนกได้ถูกต้องและตีความว่าเป็นบุคคลแปลกปลอม

- อคติด้านประชากร: ในบางกรณีที่ร้ายแรง ระบบจดจำใบหน้าที่ถูกฝึกด้วยข้อมูลของคนกลุ่มชาติพันธุ์หนึ่งเป็นส่วนใหญ่ อาจมีความแม่นยำลดลงอย่างมากเมื่อต้องวิเคราะห์ใบหน้าของคนจากกลุ่มชาติพันธุ์อื่น

อคติเหล่านี้ทำให้ AI ซึ่งควรจะเป็นกลาง กลายเป็นระบบที่ตัดสินใจอย่างไม่เป็นธรรมและอาจเป็นอันตรายได้

ข้อผิดพลาดของอัลกอริทึมและ ‘Edge Cases’

Edge Cases คือสถานการณ์ที่เกิดขึ้นไม่บ่อยและอยู่นอกเหนือการคาดการณ์ของโปรแกรมเมอร์ ซึ่งอาจทำให้อัลกอริทึมทำงานผิดพลาดได้ ตัวอย่างเช่น

- สภาพแวดล้อมที่ไม่ปกติ: หมอกลงจัด, ฝนตกหนักจนภาพพร่ามัว, หรือแสงสะท้อนจากกระจก อาจทำให้เซ็นเซอร์ของ AI ตีความภาพผิดเพี้ยนไป

- เหตุการณ์ที่ไม่คาดฝัน: พนักงานส่งของทำของตกและต้องก้มลงเก็บอย่างรวดเร็ว AI อาจตีความท่าทางดังกล่าวว่าเป็นการเคลื่อนไหวที่น่าสงสัยและเป็นภัยคุกคาม

การโจมตีทางไซเบอร์: ภัยคุกคามที่มองไม่เห็น

ระบบ AI ที่เชื่อมต่อกับอินเทอร์เน็ตย่อมมีความเสี่ยงต่อการถูกโจมตีทางไซเบอร์ ผู้ไม่หวังดีอาจเจาะเข้าระบบเพื่อควบคุมการทำงานของยาม AI โดยมีเป้าหมายที่หลากหลาย เช่น

- สร้างความโกลาหล: สั่งให้ระบบล็อกดาวน์โดยไม่มีเหตุผล เพื่อสร้างความวุ่นวายและทำลายความน่าเชื่อถือของระบบ

- เบี่ยงเบนความสนใจ: สั่งให้ AI ไล่ล่าเป้าหมายปลอม (เช่น พนักงานส่งของ) เพื่อสร้างโอกาสให้ผู้บุกรุกตัวจริงสามารถเข้าไปในพื้นที่อื่นได้โดยไม่มีใครสังเกต

- เข้าควบคุมโดยตรง: ยึดครองระบบเพื่อใช้เป็นเครื่องมือในการก่ออาชญากรรม เช่น ปิดกั้นทางหนีของเหยื่อ หรือเปิดทางให้ผู้บุกรุก

เปรียบเทียบระบบรักษาความปลอดภัย: ยามมนุษย์ ปะทะ ยาม AI

การตัดสินใจเลือกระหว่างระบบรักษาความปลอดภัยแบบดั้งเดิมที่ใช้มนุษย์กับระบบ AI อัตโนมัติ จำเป็นต้องพิจารณาข้อดีข้อเสียในหลายมิติ

| คุณสมบัติ | เจ้าหน้าที่รักษาความปลอดภัย (มนุษย์) | ระบบยาม AI อัตโนมัติ |

|---|---|---|

| ประสิทธิภาพการเฝ้าระวัง | อาจมีความเหนื่อยล้า สมาธิลดลง หรือเกิดความประมาทได้ | สามารถเฝ้าระวังได้ต่อเนื่อง 24/7 โดยไม่เหนื่อยล้า และประมวลผลกล้องหลายตัวพร้อมกันได้ |

| ความเร็วในการตอบสนอง | ขึ้นอยู่กับประสบการณ์และการตัดสินใจของแต่ละบุคคล | ตอบสนองต่อเหตุการณ์ที่ตรวจจับได้ในเสี้ยววินาที แต่ขึ้นอยู่กับโปรแกรมที่ตั้งไว้ |

| การตัดสินใจที่ซับซ้อน | สามารถใช้วิจารณญาณ สามัญสำนึก และเข้าใจบริบทที่ซับซ้อนได้ดีกว่า | การตัดสินใจขึ้นอยู่กับข้อมูลที่ถูกฝึกฝนมา อาจผิดพลาดในสถานการณ์ที่ไม่เคยเจอ (Edge Cases) |

| อคติ (Bias) | อาจมีอคติส่วนบุคคล (Personal Bias) ต่อเชื้อชาติหรือรูปลักษณ์ภายนอก | อาจมีอคติจากข้อมูล (Data Bias) ที่ใช้ในการฝึกฝน ซึ่งอาจนำไปสู่การตัดสินใจที่ผิดพลาดอย่างเป็นระบบ |

| ต้นทุน | มีค่าใช้จ่ายต่อเนื่องในระยะยาว (เงินเดือน, สวัสดิการ) | มีต้นทุนเริ่มต้นในการติดตั้งสูง แต่ค่าใช้จ่ายในการดำเนินงานระยะยาวอาจต่ำกว่า |

| ความรับผิดชอบ | บุคคลและบริษัทรักษาความปลอดภัยเป็นผู้รับผิดชอบโดยตรง | มีความซับซ้อนในการระบุผู้รับผิดชอบ (ผู้พัฒนา, ผู้ติดตั้ง, หรือเจ้าของระบบ) |

ผลกระทบที่ตามมา: เมื่อระบบความปลอดภัยล้มเหลว

เหตุการณ์ที่ระบบยาม AI ทำงานผิดพลาดอย่างรุนแรงไม่ได้ส่งผลกระทบเพียงแค่ในระดับบุคคล แต่ยังสร้างแรงกระเพื่อมในวงกว้าง ทั้งในด้านสังคม กฎหมาย และความเชื่อมั่นต่อเทคโนโลยี

ความปลอดภัยส่วนบุคคลและสิทธิขั้นพื้นฐาน

ผลกระทบที่ชัดเจนที่สุดคือภัยคุกคามต่อความปลอดภัยทางกายภาพของบุคคลที่ถูกระบบมองว่าเป็นผู้บุกรุก เช่น พนักงานส่งของที่อาจได้รับบาดเจ็บจากการไล่ล่าหรือการป้องกันตัวจากระบบอัตโนมัติ นอกจากนี้ การสั่งล็อกดาวน์โดยไม่มีเหตุผลยังเป็นการละเมิดสิทธิในการเดินทางและเสรีภาพของผู้อยู่อาศัยทั้งหมด ทำให้พวกเขากลายเป็นนักโทษในบ้านของตัวเอง

คำถามถึงความรับผิดชอบทางกฎหมาย

เมื่อเกิดความเสียหายขึ้น คำถามที่ตามมาคือ “ใครคือผู้รับผิดชอบ?” การหาคำตอบนั้นไม่ใช่เรื่องง่าย:

- บริษัทผู้พัฒนา AI: อาจต้องรับผิดชอบหากพิสูจน์ได้ว่าอัลกอริทึมมีข้อบกพร่องหรือมีอคติอย่างชัดเจน

- ผู้ติดตั้งระบบ: อาจมีความผิดหากติดตั้งเซ็นเซอร์หรือตั้งค่าระบบไม่ถูกต้อง

- นิติบุคคลของหมู่บ้าน: อาจต้องรับผิดชอบในฐานะผู้ใช้งานที่เลือกนำเทคโนโลยีมาใช้โดยไม่พิจารณาความเสี่ยงอย่างรอบคอบ

ความซับซ้อนนี้ชี้ให้เห็นถึงความจำเป็นในการสร้างกรอบกฎหมายที่ชัดเจนเพื่อรองรับความผิดพลาดที่เกิดจากระบบอัตโนมัติ

การสั่นคลอนความไว้วางใจในเทคโนโลยี

เหตุการณ์ลักษณะนี้เพียงครั้งเดียวสามารถทำลายความไว้วางใจของสาธารณชนที่มีต่อเทคโนโลยี AI ได้ในระยะยาว ผู้คนอาจเริ่มตั้งคำถามถึงความปลอดภัยของเทคโนโลยีอื่นๆ ในชีวิตประจำวัน เช่น รถยนต์ไร้คนขับ หรือระบบผู้ช่วยอัจฉริยะในบ้าน ซึ่งอาจส่งผลให้การยอมรับและพัฒนาเทคโนโลยีในภาพรวมเป็นไปได้ช้าลง

แนวทางการป้องกันและอนาคตของความปลอดภัย AI

เพื่อป้องกันไม่ให้สถานการณ์เลวร้ายเช่นนี้เกิดขึ้นจริง การพัฒนาระบบความปลอดภัย AI จำเป็นต้องดำเนินไปพร้อมกับมาตรการป้องกันที่รัดกุมและกรอบการทำงานที่มีความรับผิดชอบ

การออกแบบที่ต้องมีมนุษย์ควบคุม (Human-in-the-Loop)

หลักการที่สำคัญที่สุดคือ ระบบ AI ไม่ควรมีอำนาจตัดสินใจในเรื่องความเป็นความตายหรือการใช้กำลังโดยสมบูรณ์ ควรมีการออกแบบให้มี “มนุษย์” อยู่ในวงจรการตัดสินใจเสมอ เช่น

- ระบบแจ้งเตือนเพื่อยืนยัน: แทนที่จะสั่งล็อกดาวน์ทันที AI ควรส่งสัญญาณเตือนพร้อมภาพและข้อมูลไปยังเจ้าหน้าที่รักษาความปลอดภัยที่เป็นมนุษย์เพื่อทำการตรวจสอบและยืนยันคำสั่งก่อน

- ปุ่มฉุกเฉิน (Panic Button): ต้องมีกลไกที่ชัดเจนและเข้าถึงง่ายสำหรับเจ้าหน้าที่หรือผู้อยู่อาศัยในการสั่งหยุดการทำงานของระบบ AI ทั้งหมดได้ทันทีในกรณีฉุกเฉิน

การตรวจสอบและทดสอบอย่างเข้มงวด

ก่อนนำระบบมาใช้งานจริง ควรมีการทดสอบอย่างละเอียดในสภาพแวดล้อมจำลองที่หลากหลาย เพื่อค้นหาและแก้ไขปัญหา “Edge Cases” และอคติที่อาจซ่อนอยู่ในอัลกอริทึม นอกจากนี้ ควรมีการตรวจสอบ (Audit) การทำงานของ AI อย่างสม่ำเสมอโดยหน่วยงานอิสระภายนอก เพื่อให้แน่ใจว่าระบบยังคงทำงานได้อย่างถูกต้องและเป็นธรรม

กรอบกฎหมายและจริยธรรมที่ชัดเจน

ภาครัฐและหน่วยงานที่เกี่ยวข้องจำเป็นต้องร่วมกันพัฒนากฎระเบียบและมาตรฐานสำหรับระบบ AI ที่ใช้ในงานด้านความปลอดภัย เพื่อกำหนดขอบเขตความสามารถของ AI กำหนดมาตรฐานความปลอดภัยทางไซเบอร์ และสร้างแนวทางที่ชัดเจนเกี่ยวกับความรับผิดชอบทางกฎหมายเมื่อเกิดข้อผิดพลาดขึ้น

บทสรุป: สมดุลระหว่างนวัตกรรมและความรับผิดชอบ

เรื่องราวสมมติของ AI ยามหมู่บ้านคลั่ง! ล็อกดาวน์ไล่ล่าคนส่งของ เป็นเครื่องเตือนใจที่ทรงพลังว่า แม้เทคโนโลยีปัญญาประดิษฐ์จะมีศักยภาพมหาศาลในการยกระดับคุณภาพชีวิตและความปลอดภัย แต่การนำมาใช้งานโดยปราศจากความเข้าใจในข้อจำกัดและความเสี่ยงอย่างถ่องแท้ อาจนำไปสู่ผลลัพธ์ที่น่าสะพรึงกลัวและสร้างความเสียหายเกินกว่าจะประเมินได้

อนาคตของหมู่บ้านอัจฉริยะและระบบความปลอดภัย AI ไม่ได้ขึ้นอยู่กับความสามารถของอัลกอริทึมเพียงอย่างเดียว แต่ขึ้นอยู่กับความสามารถของเราในการสร้างสมดุลระหว่างนวัตกรรมทางเทคโนโลยีและความรับผิดชอบทางจริยธรรม การออกแบบระบบที่ให้ความสำคัญกับมนุษย์ การสร้างกลไกการควบคุมและตรวจสอบที่เข้มแข็ง และการพัฒนากรอบกฎหมายที่เท่าทัน คือกุญแจสำคัญที่จะทำให้มั่นใจได้ว่าเทคโนโลยีจะยังคงเป็นเครื่องมือที่รับใช้มนุษย์ ไม่ใช่เจ้านายที่ควบคุมเรา การก้าวไปข้างหน้าอย่างระมัดระวังและรอบคอบจึงเป็นหนทางเดียวที่จะเก็บเกี่ยวประโยชน์จาก AI ได้อย่างเต็มศักยภาพและปลอดภัยสำหรับทุกคนในสังคม