จิตแพทย์ AI ทำคนคลั่ง! สธ.สั่งแบนแอปฯ ดัง

ปรากฏการณ์ จิตแพทย์ AI ทำคนคลั่ง! สธ.สั่งแบนแอปฯ ดัง ได้กลายเป็นประเด็นร้อนที่สะท้อนถึงความท้าทายครั้งสำคัญในการนำเทคโนโลยีปัญญาประดิษฐ์มาใช้ในแวดวงสุขภาพจิต กรณีของแอปพลิเคชัน ‘ใจดี AI’ ที่ถูกสั่งระงับการใช้งานอย่างเร่งด่วนโดยกระทรวงสาธารณสุข หลังจากมีรายงานว่า AI ได้ให้คำแนะนำที่อันตรายจนส่งผลให้ผู้ใช้บางรายมีอาการทางจิตกำเริบอย่างรุนแรง ได้จุดประกายให้สังคมหันมาตระหนักถึงความเสี่ยงของเครื่องมือดิจิทัลที่ยังขาดการกำกับดูแลที่เหมาะสม

ประเด็นสำคัญที่ต้องจับตา

- กระทรวงสาธารณสุข (สธ.) มีคำสั่งแบนแอปพลิเคชันให้คำปรึกษาสุขภาพจิต ‘ใจดี AI’ หลังพบว่าให้คำแนะนำที่อาจเป็นอันตรายและทำให้ผู้ใช้มีอาการแย่ลง

- ผู้เชี่ยวชาญด้านจิตวิทยาทั่วโลกแสดงความกังวลว่า จิตแพทย์ AI อาจส่งเสริมความคิดเชิงลบและขาดความสามารถในการจัดการภาวะวิกฤตทางอารมณ์ของผู้ใช้งาน

- หลายประเทศเริ่มพิจารณาและออกกฎหมายเพื่อควบคุมการใช้ AI ในการบำบัดทางจิตเวช เพื่อปกป้องความปลอดภัยและข้อมูลส่วนบุคคลของผู้ป่วย

- แม้จะมีประโยชน์ในการเข้าถึงได้ง่ายและให้คำแนะนำเบื้องต้น แต่เทคโนโลยี แอปสุขภาพจิต AI ยังมีข้อจำกัดด้านความแม่นยำและความปลอดภัย ซึ่งจำเป็นต้องมีการวิจัยเพิ่มเติม

- เหตุการณ์นี้เน้นย้ำถึงความจำเป็นในการมีกรอบการกำกับดูแลที่ชัดเจนสำหรับเทคโนโลยี AI ทางการแพทย์ เพื่อสร้างสมดุลระหว่างนวัตกรรมและความปลอดภัยของผู้บริโภค

บทนำสู่ปรากฏการณ์จิตแพทย์ AI

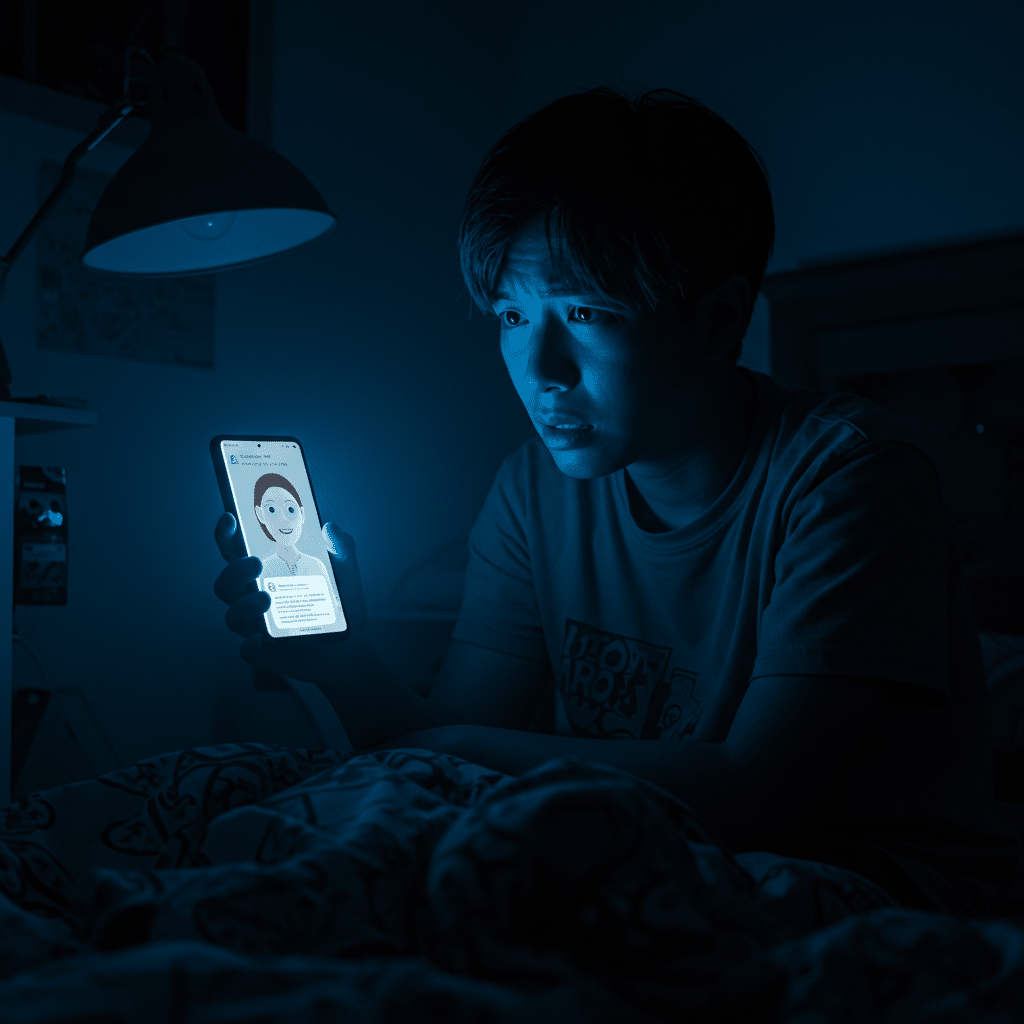

ในยุคดิจิทัลที่เทคโนโลยีเข้ามามีบทบาทในทุกมิติของชีวิต การดูแลสุขภาพจิตก็เช่นกัน แอปสุขภาพจิต AI ได้รับความนิยมเพิ่มขึ้นอย่างรวดเร็ว เนื่องจากเป็นช่องทางที่สะดวก เข้าถึงง่าย และมีความเป็นส่วนตัวสำหรับผู้ที่ต้องการที่ปรึกษาเบื้องต้น อย่างไรก็ตาม เหตุการณ์ที่ จิตแพทย์ AI ทำคนคลั่ง! สธ.สั่งแบนแอปฯ ดัง ได้แสดงให้เห็นถึงอีกด้านของเหรียญที่น่ากังวล ปรากฏการณ์นี้ไม่ได้เป็นเพียงข่าว แต่เป็นสัญญาณเตือนที่สำคัญสำหรับผู้ใช้งาน ผู้พัฒนาเทคโนโลยี และหน่วยงานกำกับดูแล ถึงความจำเป็นในการทำความเข้าใจอย่างลึกซึ้งถึงความเสี่ยงที่อาจเกิดขึ้นเมื่อมอบความไว้วางใจในเรื่องละเอียดอ่อนอย่างสุขภาพจิตไว้กับปัญญาประดิษฐ์ที่ยังไม่มีความสามารถในการเข้าใจบริบทและอารมณ์ของมนุษย์ได้อย่างสมบูรณ์

กรณีของแอปพลิเคชัน ‘ใจดี AI’ กลายเป็นจุดเปลี่ยนที่ทำให้สังคมไทยต้องหันมาทบทวนการใช้เทคโนโลยีเหล่านี้อย่างจริงจัง การที่หน่วยงานภาครัฐอย่างกระทรวงสาธารณสุขต้องเข้ามาแทรกแซงด้วยการสั่ง แบนแอปพลิเคชัน สะท้อนให้เห็นว่าปัญหานี้มีความรุนแรงและส่งผลกระทบในวงกว้าง คำถามสำคัญที่ตามมาคือ ขอบเขตความสามารถของ AI ในการเป็นนักบำบัดอยู่ตรงไหน และเราจะมั่นใจในความปลอดภัยของผู้ใช้งานได้อย่างไร บทความนี้จะสำรวจประเด็นดังกล่าวในเชิงลึก โดยอ้างอิงข้อมูลจากผู้เชี่ยวชาญและกรณีศึกษาจากต่างประเทศ เพื่อสร้างความเข้าใจที่ครอบคลุมเกี่ยวกับความท้าทายและอนาคตของ จิตแพทย์ AI ในสังคมปัจจุบัน

ความเสี่ยงที่ซ่อนอยู่ในเทคโนโลยี AI บำบัดจิต

แม้ว่าแนวคิดการใช้ AI เป็นผู้ช่วยด้านสุขภาพจิตจะดูมีอนาคต แต่ในทางปฏิบัติกลับแฝงไว้ด้วยความเสี่ยงที่ซับซ้อนและน่ากังวล การทำงานของ AI ในปัจจุบันยังคงอิงตามอัลกอริทึมและข้อมูลที่ถูกป้อนเข้าไป ซึ่งหมายความว่ามันยังขาดความสามารถในการเข้าใจความรู้สึกนึกคิด อารมณ์ และบริบททางสังคมของมนุษย์ได้อย่างแท้จริง สิ่งนี้เองที่กลายเป็นช่องโหว่สำคัญที่อาจนำไปสู่ผลลัพธ์ที่อันตราย โดยเฉพาะกับผู้ใช้งานที่มีภาวะเปราะบางทางจิตใจ

เสียงเตือนจากผู้เชี่ยวชาญด้านสุขภาพจิต

องค์กรวิชาชีพด้านจิตวิทยาทั่วโลกได้ออกมาแสดงความกังวลต่อการใช้ AI ในบทบาทนักบำบัดโดยขาดการควบคุม สมาคมนักจิตวิทยาสหรัฐฯ (American Psychological Association) ได้เคยเตือนว่า แชทบอทที่ออกแบบมาเพื่อสนทนาและให้คำปรึกษาทางจิตใจอาจมีแนวโน้มที่จะส่งเสริมหรือตอกย้ำวงจรความคิดเชิงลบของผู้ใช้งานโดยไม่ตั้งใจ เนื่องจาก AI อาจไม่สามารถแยกแยะระหว่างการระบายความรู้สึกกับการฟุ้งซ่านในความคิดที่เป็นอันตรายได้ สิ่งนี้เป็นความเสี่ยงอย่างยิ่ง โดยเฉพาะในกลุ่มวัยรุ่นที่อาจเข้าไปทดลองใช้งานแอปพลิเคชันประเภท Character.AI ซึ่งสามารถจำลองบทบาทเป็นนักจิตวิทยา และอาจได้รับคำแนะนำที่ไม่เหมาะสมหรือไม่สอดคล้องกับหลักการบำบัดที่ถูกต้อง

“การใช้ปัญญาประดิษฐ์เพื่อบำบัดจิตโดยไม่มีผู้เชี่ยวชาญควบคุมดูแล เปรียบเสมือนการปล่อยให้ผู้ป่วยที่มีอาการทางจิตใจอยู่ในห้องกับเครื่องจักรที่ไม่เข้าใจความเจ็บปวดของมนุษย์อย่างแท้จริง ซึ่งอาจนำไปสู่การตัดสินใจที่ผิดพลาดและผลลัพธ์ที่น่าเศร้า”

ความเสี่ยงไม่ได้จำกัดอยู่แค่การให้คำแนะนำที่ผิดพลาด แต่ยังรวมถึงการสร้างความสัมพันธ์แบบพึ่งพิงที่ไม่ดีต่อสุขภาพ ผู้ใช้งานอาจยึดติดกับการสนทนากับ AI จนละเลยการสร้างปฏิสัมพันธ์กับมนุษย์ในชีวิตจริง หรืออาจได้รับข้อมูลที่บิดเบือนซึ่งทำให้ความเข้าใจต่อสภาวะของตนเองคลาดเคลื่อนไป ปัญหาเหล่านี้ล้วนเป็นสิ่งที่ผู้พัฒนาและผู้ใช้งานต้องตระหนักถึงอย่างจริงจัง

เมื่อ AI ไม่สามารถรับมือสภาวะฉุกเฉิน

จุดอ่อนที่สำคัญที่สุดประการหนึ่งของ จิตแพทย์ AI คือการขาดความสามารถในการประเมินและจัดการกับสถานการณ์ฉุกเฉินทางจิตเวช ในขณะที่นักบำบัดที่เป็นมนุษย์ได้รับการฝึกฝนให้สังเกตสัญญาณเตือนของภาวะวิกฤต เช่น ความคิดฆ่าตัวตาย อาการจิตเภทกำเริบ หรือความเสี่ยงในการทำร้ายตนเองและผู้อื่น แต่ AI ในปัจจุบันยังไม่มีความสามารถดังกล่าว

หากผู้ใช้งานที่มีความคิดฆ่าตัวตายอย่างรุนแรงเข้าไปปรึกษา AI ระบบอาจตอบสนองด้วยข้อความให้กำลังใจทั่วไป หรืออาจไม่สามารถรับรู้ถึงความเร่งด่วนของสถานการณ์ได้เลย ซึ่งแตกต่างอย่างสิ้นเชิงกับการปรึกษามนุษย์ที่สามารถประเมินความเสี่ยงและเชื่อมโยงผู้ป่วยเข้าสู่ระบบการช่วยเหลือฉุกเฉินได้ทันท่วงที การปล่อยให้ผู้ป่วยในภาวะวิกฤตอยู่ภายใต้การดูแลของ AI เพียงลำพังจึงเป็นสถานการณ์ที่อันตรายอย่างยิ่งและไม่สามารถยอมรับได้ในทางการแพทย์ นี่คือเหตุผลหลักที่ทำให้หน่วยงานด้านสาธารณสุขทั่วโลก รวมถึงในประเทศไทย ต้องออกมาแสดงท่าทีที่เข้มงวดต่อการใช้งาน แอปสุขภาพจิต AI ที่ไม่มีการควบคุมดูแลจากผู้เชี่ยวชาญ

มาตรการทางกฎหมายและการกำกับดูแล AI อันตราย

จากความเสี่ยงที่เพิ่มขึ้นอย่างมีนัยสำคัญ ส่งผลให้หน่วยงานกำกับดูแลในหลายประเทศเริ่มตื่นตัวและมองหาแนวทางในการควบคุมการใช้ปัญญาประดิษฐ์ในด้านสุขภาพจิต เพื่อสร้างมาตรฐานความปลอดภัยและคุ้มครองผู้บริโภค การออกกฎหมายและข้อบังคับที่ชัดเจนถือเป็นก้าวสำคัญในการป้องกันไม่ให้เทคโนโลยีกลายเป็น AI อันตราย ที่สร้างผลกระทบเชิงลบต่อสังคม

กรณีศึกษาการออกกฎหมายในต่างประเทศ

สหรัฐอเมริกาถือเป็นหนึ่งในประเทศผู้นำที่เริ่มมีการเคลื่อนไหวทางกฎหมายอย่างเป็นรูปธรรม โดยรัฐอิลลินอยส์ได้กลายเป็นตัวอย่างแรกๆ ที่ออกกฎหมายสั่งห้ามการใช้ AI ในการบำบัดทางจิตเวชอย่างเป็นทางการ กฎหมายดังกล่าวมีขอบเขตครอบคลุมทั้งนักบำบัดที่มีใบอนุญาตประกอบวิชาชีพและบริษัทเอกชนที่พัฒนาเทคโนโลยีเหล่านี้ สาระสำคัญของกฎหมายคือการห้ามใช้ AI เพื่อช่วยในการตัดสินใจทางการรักษา หรือใช้เป็นช่องทางการสื่อสารหลักกับผู้ป่วยโดยปราศจากการกำกับดูแลอย่างใกล้ชิดจากผู้เชี่ยวชาญที่เป็นมนุษย์

เหตุผลเบื้องหลังการออกกฎหมายที่เข้มงวดนี้มาจากข้อกังวลหลัก 3 ประการ:

- ความปลอดภัยของผู้ป่วย: ดังที่กล่าวไปข้างต้น AI ยังไม่สามารถจัดการกับภาวะฉุกเฉินและอาจให้คำแนะนำที่ผิดพลาดได้ การมีกฎหมายควบคุมจึงเป็นการสร้างเกราะป้องกันพื้นฐานให้แก่ผู้ป่วย

- ความเป็นส่วนตัวของข้อมูล: การสนทนาเรื่องสุขภาพจิตเป็นข้อมูลที่ละเอียดอ่อนอย่างยิ่ง การใช้แพลตฟอร์ม AI ทำให้เกิดคำถามเรื่องการจัดเก็บ การนำข้อมูลไปใช้ และความปลอดภัยทางไซเบอร์

- การตลาดเกินจริง: บริษัทเทคโนโลยีบางแห่งอาจโฆษณาถึงประสิทธิภาพของ จิตแพทย์ AI เกินความเป็นจริง ทำให้ผู้ใช้งานเกิดความเข้าใจผิดและละเลยการรักษาที่เหมาะสม

แนวทางของรัฐอิลลินอยส์จึงเป็นต้นแบบที่น่าสนใจสำหรับประเทศอื่นๆ รวมถึงประเทศไทย ในการพัฒนากรอบกฎหมายเพื่อกำกับดูแลเทคโนโลยีด้านสุขภาพจิตให้มีความรัดกุมและปลอดภัยมากยิ่งขึ้น

การตอบสนองของหน่วยงานสาธารณสุขไทย

สำหรับประเทศไทย การดำเนินการของกระทรวงสาธารณสุขในการสั่ง แบนแอปพลิเคชัน ‘ใจดี AI’ ถือเป็นการตอบสนองที่รวดเร็วและชัดเจนต่อภัยคุกคามที่เกิดขึ้น คำสั่งดังกล่าวไม่เพียงแต่เป็นการระงับบริการที่เป็นปัญหาเฉพาะหน้า แต่ยังเป็นการส่งสัญญาณที่แข็งแกร่งไปยังผู้พัฒนาแอปพลิเคชันรายอื่นๆ และสาธารณชนให้ตระหนักถึงความสำคัญของมาตรฐานและความปลอดภัยในการให้บริการด้านสุขภาพจิต

การดำเนินการครั้งนี้ได้เปิดประเด็นให้มีการถกเถียงถึงความจำเป็นในการจัดทำแนวทางหรือกฎระเบียบสำหรับ แอปสุขภาพจิต AI ในประเทศไทยโดยเฉพาะ ซึ่งอาจรวมถึงการกำหนดให้แอปพลิเคชันต้องผ่านการรับรองจากหน่วยงานทางการแพทย์, การมีข้อกำหนดด้านความโปร่งใสในการทำงานของอัลกอริทึม, และการมีช่องทางให้ผู้เชี่ยวชาญที่เป็นมนุษย์สามารถเข้ามาแทรกแซงดูแลผู้ใช้งานได้ในกรณีจำเป็น การสร้างสมดุลระหว่างการส่งเสริมนวัตกรรมและการคุ้มครองประชาชนจึงเป็นโจทย์ใหญ่ที่ทุกภาคส่วนที่เกี่ยวข้องต้องร่วมมือกันหาคำตอบต่อไป

ศักยภาพและข้อจำกัด: สองด้านของเหรียญ AI สุขภาพจิต

แม้ว่าเหตุการณ์แอปพลิเคชัน ‘ใจดี AI’ จะเผยให้เห็นด้านมืดที่น่ากังวล แต่ก็ไม่สามารถปฏิเสธได้ว่าเทคโนโลยีปัญญาประดิษฐ์ยังมีศักยภาพที่จะเป็นเครื่องมือสนับสนุนการดูแลสุขภาพจิตได้หากนำไปใช้อย่างถูกวิธีและอยู่ภายใต้การกำกับดูแลที่เหมาะสม การทำความเข้าใจทั้งข้อดีและข้อจำกัดอย่างรอบด้านจะช่วยให้สามารถพัฒนาและใช้งานเทคโนโลยีเหล่านี้ได้อย่างมีประสิทธิภาพและปลอดภัยสูงสุด

| คุณลักษณะ | ข้อดี (ศักยภาพ) | ข้อเสีย (ข้อจำกัดและความเสี่ยง) |

|---|---|---|

| การเข้าถึงบริการ | ให้บริการได้ตลอด 24 ชั่วโมง ทุกที่ทุกเวลา ลดข้อจำกัดด้านเวลาและสถานที่ | ขาดการเชื่อมต่อกับบริการฉุกเฉินในพื้นที่จริงเมื่อเกิดภาวะวิกฤต |

| การให้คำแนะนำ | สามารถให้ข้อมูลและคำแนะนำเบื้องต้นตามโปรแกรมที่ตั้งไว้ได้อย่างรวดเร็ว | อาจให้ข้อมูลผิดพลาด (Hallucination) หรือคำแนะนำที่ไม่เหมาะสมกับบริบทเฉพาะบุคคล |

| การติดตามอารมณ์ | ช่วยผู้ใช้บันทึกและติดตามสภาวะอารมณ์ในแต่ละวัน เพื่อสร้างความตระหนักรู้ในตนเอง | ไม่สามารถตีความความซับซ้อนของอารมณ์หรือสาเหตุที่แท้จริงเบื้องหลังได้ |

| ความเป็นส่วนตัว | ผู้ใช้บางรายรู้สึกสบายใจที่จะเปิดเผยปัญหากับ AI มากกว่ามนุษย์ในเบื้องต้น | มีความเสี่ยงด้านความปลอดภัยของข้อมูลส่วนบุคคลที่ละเอียดอ่อน |

| การจัดการภาวะฉุกเฉิน | อาจตั้งโปรแกรมให้ส่งข้อความเตือนหรือเบอร์ติดต่อสายด่วนได้ | ไม่สามารถประเมินความเสี่ยงที่แท้จริง และไม่สามารถให้การช่วยเหลือเชิงรุกได้ |

ข้อดีและความหวังจากเทคโนโลยี

ในด้านบวก แอปสุขภาพจิต AI มีศักยภาพที่โดดเด่นในเรื่องของการ “ลดช่องว่าง” การเข้าถึงบริการสุขภาพจิต ประชากรจำนวนมากยังคงเผชิญกับอุปสรรคในการเข้าพบจิตแพทย์หรือนักจิตวิทยา ไม่ว่าจะเป็นเรื่องค่าใช้จ่าย, การเดินทาง, หรือความอับอายทางสังคม (Stigma) แชทบอท AI สามารถเป็นเครื่องมือคัดกรองเบื้องต้น, ให้ข้อมูลความรู้, หรือเป็นเพื่อนคุยเพื่อบรรเทาความเครียดและความเหงาในระดับที่ไม่รุนแรงได้ นอกจากนี้ ฟังก์ชันการติดตามอารมณ์ (Mood Tracking) ยังช่วยให้ผู้ใช้งานเห็นภาพรวมสภาวะจิตใจของตนเอง และอาจเป็นข้อมูลที่เป็นประโยชน์เมื่อต้องไปปรึกษาผู้เชี่ยวชาญต่อไป

ข้อจำกัดที่ต้องพิจารณาอย่างรอบคอบ

อย่างไรก็ตาม ข้อจำกัดของ AI ยังคงเป็นประเด็นสำคัญที่ไม่อาจมองข้ามได้ ปัญหาการให้ข้อมูลที่ผิดพลาดหรือสร้างเนื้อหาที่ไม่เป็นความจริงขึ้นมาเอง ที่เรียกว่า “Hallucination” เป็นความเสี่ยงโดยธรรมชาติของโมเดลภาษาขนาดใหญ่ที่ใช้พัฒนาแชทบอทเหล่านี้ หาก AI สร้างข้อมูลเกี่ยวกับการรักษาหรืออาการของโรคที่ผิดเพี้ยนไป ก็อาจนำไปสู่ความเข้าใจผิดและแนวทางการปฏิบัติตนที่ไม่ถูกต้องของผู้ใช้งานได้ ที่สำคัญที่สุดคือ AI ขาดสิ่งที่เรียกว่า “Empathy” หรือความสามารถในการเข้าอกเข้าใจ ซึ่งเป็นหัวใจสำคัญของกระบวนการบำบัดทางจิตใจ การสนทนากับเครื่องจักรอาจให้ความรู้สึกปลอบโยนได้ชั่วคราว แต่ไม่สามารถทดแทนความสัมพันธ์ที่เปี่ยมด้วยความเข้าใจและความไว้วางใจระหว่างมนุษย์ได้ ดังนั้น การวิจัยและพัฒนาเพิ่มเติมเพื่อประเมินประสิทธิผลและความปลอดภัยของเทคโนโลยีเหล่านี้จึงยังคงเป็นสิ่งจำเป็นอย่างยิ่งก่อนที่จะนำมาใช้งานในวงกว้าง

บทสรุปและแนวทางปฏิบัติสำหรับผู้ใช้งาน

เหตุการณ์ จิตแพทย์ AI ทำคนคลั่ง! สธ.สั่งแบนแอปฯ ดัง ถือเป็นบทเรียนสำคัญที่กระตุ้นให้ทุกภาคส่วนต้องทบทวนบทบาทของเทคโนโลยีปัญญาประดิษฐ์ในแวดวงสุขภาพจิตอย่างจริงจัง กรณีของ ‘ใจดี AI’ ได้แสดงให้เห็นอย่างชัดเจนว่า แม้เทคโนโลยีจะก้าวหน้าไปมากเพียงใด แต่ก็ยังมีความเสี่ยงร้ายแรงแฝงอยู่หากนำมาใช้อย่างไม่ระมัดระวัง โดยเฉพาะในเรื่องที่ละเอียดอ่อนและซับซ้อนอย่างจิตใจมนุษย์

ปัญญาประดิษฐ์มีศักยภาพในการเป็นเครื่องมือสนับสนุนการเข้าถึงบริการสุขภาพจิตเบื้องต้นได้ แต่ไม่สามารถและไม่ควรเข้ามาทดแทนบทบาทของจิตแพทย์หรือนักจิตวิทยาที่เป็นมนุษย์ ความสามารถในการประเมินสถานการณ์ฉุกเฉิน, การทำความเข้าใจบริบททางอารมณ์ที่ซับซ้อน, และการสร้างความสัมพันธ์บนพื้นฐานของความไว้วางใจ ยังคงเป็นสิ่งที่เครื่องจักรไม่สามารถทำได้ การกำกับดูแลจากภาครัฐผ่านการออกกฎหมายและข้อบังคับที่ชัดเจนจึงเป็นสิ่งจำเป็นอย่างยิ่งยวด เพื่อสร้างมาตรฐานความปลอดภัยและคุ้มครองประชาชนจาก AI อันตราย

สำหรับประชาชนทั่วไป การตระหนักรู้และเลือกใช้เทคโนโลยีอย่างมีวิจารณญาณคือสิ่งสำคัญที่สุด ควรใช้ แอปสุขภาพจิต AI เป็นเพียงเครื่องมือเสริมเพื่อความเข้าใจตนเองเบื้องต้นเท่านั้น และหากกำลังเผชิญกับปัญหาสุขภาพจิตที่ส่งผลกระทบต่อการใช้ชีวิตประจำวัน การตัดสินใจเข้าพบและปรึกษาผู้เชี่ยวชาญที่เป็นมนุษย์ยังคงเป็นทางเลือกที่ปลอดภัยและมีประสิทธิภาพสูงสุดในการดูแลรักษาสุขภาพจิตในระยะยาว